数据治理系列五 浅谈数据质量管理与数据处理

在数据治理的宏大体系中,数据质量管理(Data Quality Management, DQM)是确保数据资产价值得以实现的核心基石。它并非一个孤立的环节,而是与数据处理的全生命周期紧密交织、相互影响。本文将聚焦于数据质量管理,并探讨其与数据处理流程的深刻关联。

一、数据质量管理的核心内涵

数据质量管理旨在通过一系列政策、技术和流程,确保数据在其整个生命周期内(从产生到归档或销毁)满足特定用途的准确性、完整性、一致性、及时性和可靠性等要求。其核心目标在于提升数据的可信度与可用性,使数据真正成为驱动决策、优化运营的可靠资产。

关键维度通常包括:

- 准确性:数据是否真实、无误地反映了其所描述的实体或事件。

- 完整性:所需的数据是否齐全,有无缺失值或缺失记录。

- 一致性:数据在不同系统、不同时间点是否遵循统一的定义、格式和逻辑规则,且内部无矛盾。

- 及时性:数据在需要时是否可用,并能反映当前或特定时间点的状态。

- 唯一性:实体或事件是否在系统中被重复记录。

- 有效性:数据是否符合预先定义的业务规则、格式或值域范围。

二、数据处理:质量管理的“主战场”

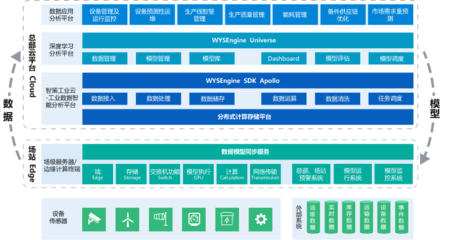

数据处理涵盖了数据的采集、清洗、转换、集成、存储、计算和应用等一系列活动。几乎每一个处理环节,都是影响和塑造数据质量的关键节点。

- 数据采集与录入:这是数据质量的“源头”。制定清晰的数据标准、提供带有验证功能的录入界面、对数据源进行可信度评估,是从根源上预防质量问题的首要步骤。

- 数据清洗与转换:这是提升数据质量最主动、最集中的环节。通过处理缺失值、纠正错误值、标准化格式、解析复杂字段、去重合并等操作,直接修复已发现的质量缺陷。清洗规则本身的质量,直接决定了产出数据的质量。

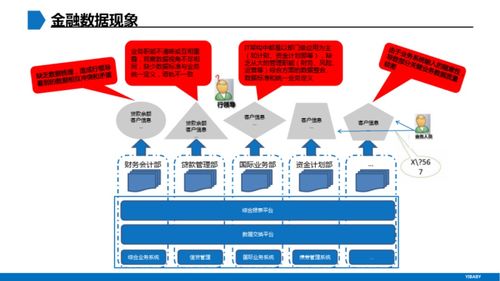

- 数据集成与交换:当数据来自多个异构系统时,确保语义、格式和标识符的一致性至关重要。映射规则不当、时间戳不同步等问题,会直接引发一致性、完整性和及时性问题。

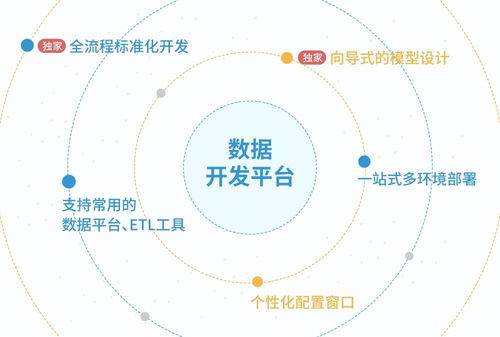

- 数据存储与计算:稳定的存储环境、清晰的数据模型、准确的ETL/ELT流程和计算逻辑,是维持数据质量在存储和加工过程中不“变质”的保障。任何计算错误或逻辑偏差都会污染下游数据。

- 数据访问与应用:最终用户在使用数据时发现的异常,是最直接的质量反馈。建立便捷的数据质量投诉与反馈通道,能使质量问题被快速发现并溯源至相应的处理环节进行修复。

三、构建融合的数据质量与处理管理闭环

有效的管理,需要将质量管控措施深度嵌入数据处理流程,形成一个持续改进的闭环:

- 事前预防:在数据处理流程的设计阶段,就嵌入质量检查点(Checkpoints)。例如,在数据接入层设置完整性校验,在转换规则中内置有效性验证。

- 事中监控与校验:在数据处理任务(尤其是ETL/ELT任务)运行时,实施过程监控。通过定义并测量关键质量指标(KQI),如任务成功率、数据记录数波动、值域合规率等,实时或准实时地发现处理过程中产生的质量异常。

- 事后评估与改进:定期对关键数据资产进行全面的质量评估,生成质量报告。将评估结果与业务影响关联分析,定位根本原因——是源头问题、处理逻辑问题,还是标准定义问题?进而驱动数据处理流程的优化、规则的修订或源系统的改造。

###

数据处理是数据的“锻造”过程,而数据质量管理则是确保这次锻造产出“优质钢材”的工艺标准与质检体系。二者不可分割。忽视质量管理的处理流程,如同没有质检的生产线,产出不可信赖;脱离处理实践的质量管理,则易流于空谈和事后补救。唯有将质量意识、控制规则和度量手段全面融入从源到端的每一个数据处理步骤,才能构建出高效、可信的数据流水线,最终释放数据的最大潜能,为数字化转型提供坚实的数据基石。

如若转载,请注明出处:http://www.hanzhengroom.com/product/35.html

更新时间:2026-01-13 14:19:17